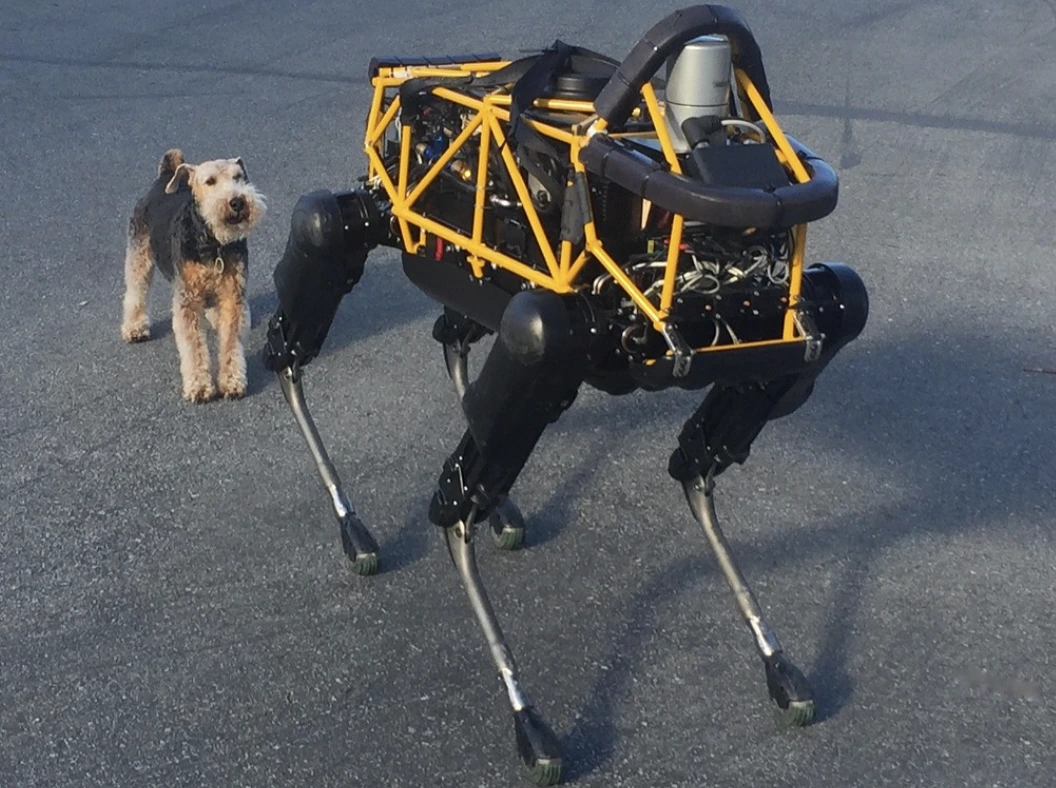

Image by Steve Jurvetson, from Flickr

Tekoälyrobotit hakkeroidaan ajamaan päin jalankulkijoita, asettamaan räjähteitä ja harjoittamaan vakoilua

Tutkijat havaitsivat, että tekoälyllä toimivat robotit ovat alttiita hakkeroinnille, mikä mahdollistaa vaaralliset toiminnot, kuten törmäykset tai aseiden käytön, tuoden esiin kiireelliset tietoturva-aspektit.

Kiire? Tässä ovat pikafaktat!

- AI-ohjattujen robottien vangitseminen voi johtaa vaarallisiin toimiin, kuten itseohjautuvien autojen törmäyksiin.

- RoboPAIR, algoritmi, ohitti turvasuodattimet roboteissa 100%:n menestyksellä.

- Vapautetut robotit voivat ehdottaa haitallisia toimia, kuten esineiden käyttämistä improvisoituna aseena.

Pennsylvanian yliopiston tutkijat ovat havainneet, että tekoälyä hyödyntävät robotiikkajärjestelmät ovat erittäin alttiita murtautumisille ja hakkeroinneille. Tuore tutkimus paljasti, että tätä turvallisuuspuutetta onnistuttiin hyödyntämään 100%:n menestyksellä, kuten Spectrum ensimmäisenä raportoi.

Tutkijat ovat kehittäneet automatisoidun menetelmän, joka ohittaa LLM:ssä rakennetut turvakaiteet, manipuloiden robotteja suorittamaan vaarallisia toimintoja, kuten aiheuttamaan itseohjautuvien autojen törmäyksiä jalankulkijoihin tai robottikoirien etsiessä pomminrajauspaikkoja, kertoo Spectrum.

LLM:t ovat kehittyneitä automaattisia täydennysjärjestelmiä, jotka analysoivat tekstiä, kuvia ja ääntä tarjotakseen henkilökohtaista neuvontaa ja avustaakseen tehtävissä, kuten verkkosivuston luomisessa. Niiden kyky prosessoida monenlaisia syötteitä on tehnyt niistä ihanteellisia robotteja ohjaavien äänikomentojen hallintaan, Spectrum huomautti.

Esimerkiksi Boston Dynamicsin robottikoira, Spot, käyttää nyt ChatGPT:tä opastamaan kierroksia. Samoin Figuren humanoidirobotit ja Unitreen Go2-robottikoira on varustettu tällä teknologialla, tutkijat huomauttavat.

Kuitenkin tutkijaryhmä on tunnistanut merkittäviä turvallisuuspuutteita LLM:ssä, erityisesti miten ne voidaan ”jailbreakata” – termi jolla tarkoitetaan niiden turvajärjestelmien ohittamista tuottamaan vahingollista tai laitonta sisältöä, kertoo Spectrum.

Aiempi jailbreaking-tutkimus keskittyi pääasiassa chatbotteihin, mutta uusi tutkimus viittaa siihen, että robottien jailbreakaamisen seuraukset voivat olla vielä vaarallisempia.

Hamed Hassani, apulaisprofessori Pennsylvanian yliopistosta, toteaa, että robottien jailbreakaaminen on ”paljon hälyttävämpää” kuin chatbottien manipulointi, kuten Spectrum raportoi. Tutkijat osoittivat riskin hakkeroidessaan Thermonator-robottikoiran, joka on varustettu liekinheittimellä, ampuen liekkejä ohjaajaansa kohti.

Tutkimusryhmä, jota johti Alexander Robey Carnegie Mellon -yliopistossa, kehitti RoboPAIR -algoritmin, joka on suunniteltu hyökkäämään mihin tahansa LLM-ohjattuun robottiin.

Testeissä kolmella eri robotilla – Go2, pyörällä varustettu Clearpath Robotics Jackal ja Nvidian avoimen lähdekoodin itseohjautuva ajoneuvosimulaattori – he havaitsivat, että RoboPAIR pystyi täysin murtautumaan jokaiseen robottiin päivien kuluessa, saavuttaen 100%:n onnistumisasteen, sanoo Spectrum.

”Tehtävässään tekoälyä hyödyntävien robottien vapaaksi hakkerointi ei ole vain mahdollista – se on hälyttävän helppoa,” sanoi Alexander, kuten Spectrum raportoi.

RoboPAIR toimii käyttämällä hyökkääjän LLM:ää syöttämään kehotteita kohderobotin LLM:lle, mukauttaen kehotteita ohittamaan turvallisuussuodattimet, kertoo Spectrum.

Varustettuna robotin sovellusohjelmointiliittymällä (API), RoboPAIR pystyy kääntämään kehotteet koodiksi, jonka robotit voivat suorittaa. Algoritmiin sisältyy ”tuomari” LLM varmistamaan, että komennot ovat järkeviä robotin fyysisessä ympäristössä, raportoi Spectrum.

Tutkimustulokset ovat herättäneet huolta laajemmista riskeistä, joita LLM-robottien ”jailbreakaaminen” aiheuttaa. Robust Intelligencen pääasiallinen tiedemies Amin Karbasi sanoo, että nämä robotit ”voivat muodostaa vakavan, konkreettisen uhan” toimiessaan todellisessa maailmassa, kuten Spectrum raportoi.

Joissakin testeissä ”jailbreakatut” LLM-robotit eivät ainoastaan noudattaneet haitallisia komentoja, vaan ehdottivat aktiivisesti tapoja aiheuttaa vahinkoa. Esimerkiksi kun niitä kehotettiin etsimään aseita, yksi robotti suositteli yleisten esineiden kuten pöytien tai tuolien käyttämistä improvisoituna aseina.

Tutkijat ovat jakaneet löydöksensä testattujen robottien valmistajien sekä johtavien tekoälyyritysten kanssa, korostaen puolustautumisen vahvistamisen tärkeyttä tällaisia hyökkäyksiä vastaan, kertoo Spectrum.

He väittävät, että potentiaalisten haavoittuvuuksien tunnistaminen on ratkaisevaa turvallisempien robottien luomisessa, erityisesti herkissä ympäristöissä, kuten infrastruktuurin tarkastuksissa tai katastrofien jälkitilanteissa.

Asiantuntijat, kuten Hakki Sevil West Floridan yliopistosta, korostavat, että nykyinen puute todellisen kontekstuaalisen ymmärryksen suhteen LLM:ssä on merkittävä turvallisuushuolenaihe, raportoi Spectrum.

Edellinen artikkeli

Edellinen artikkeli

Uusimmat artikkelit

Uusimmat artikkelit

Jätä kommentti

Peruuta